Janvier 2010. Les États-Unis sortent de la Grande Récession et l'économie mondiale est toujours en phase de reprise. Dans le secteur des technologies, on entend des rumeurs sur une tablette révolutionnaire appelée « iPad » ou « iPal » et proposée par Apple. Le nom vous échappe encore, mais vous tentez de vous faire à l'idée que quelqu'un pourrait dépenser 500 dollars pour une version agrandie de votre iPhone 3.

Vous ne le savez pas encore, mais un changement historique est en train de se produire dans le secteur de la Data Science et de l'analytique. Grâce aux diverses évolutions technologiques et culturelles, les données sont plus répandues que jamais. On cherche alors de plus en plus à leur donner un sens et à en tirer parti pour résoudre des problèmes économiques, sociaux et métier.

Dean Stoecker, PDG d'Alteryx, présente ainsi la révolution à venir : « L'ère agricole nous a aidés à nourrir la population et a permis d'obtenir des données mettant en évidence la dépendance de l'être humain vis-à-vis de la terre. L'ère industrielle nous a permis de fabriquer des produits qui ont généré des données sur la façon dont les humains interagissent avec des objets qui ne proviennent pas de cette terre. L'ère de l'information a conduit l'homme à répandre des données à la fois physiques et virtuelles. Aujourd'hui, nous vivons à l'ère de l'analyse de données où l'homme est chargé de donner un sens à toutes les données possibles pour résoudre tous les types de problèmes auxquels il est confronté. Et cette ère s'annonce palpitante. »

L'ANALYSE DE DONNÉES DU PASSÉ

Les données deviennent une marchandise

Personne n'aurait qualifié les données de « rares » au début des années 2010. Selon un rapport IDC, 1 zettaoctet (Zo) de données était généré chaque année. Mais par rapport aux 33 Zo produits en 2018 et aux 175 Zo prévus pour 2025, ce chiffre n'est qu'une goutte d'eau dans la mer.

Pour vous donner une idée, un zettaoctet représente un trillion de gigaoctets, ou un sextillion d'octets, soit plus que le nombre de respirations humaines en 2019 (77 quadrillions). Et comme vous l'aurez peut-être compris, vous les prodiges du calcul mental, passer de 1 à 175 Zo représente une augmentation de 17 400 %. Même l'USS Enterprise devrait faire preuve d'une certaine audace pour explorer des données de cette ampleur.

Mais à quoi doit-on cette folle croissance ?

Première cause : la prolifération des données. Plusieurs facteurs y ont contribué, mais peut-être surtout l'apparition de l'Internet des Objets (IoT). Soudain, tous nos appareils IoT, autrement dit les équipements connectés à Internet via le Wi-Fi ou d'autres réseaux de fréquence tels que le Bluetooth ou le cellulaire, se sont mis à générer des données. De nos smartphones à nos réfrigérateurs intelligents, ces appareils ont commencé à produire des données sur tout : de notre pratique sportive à la quantité de lait écrémé qu'il nous reste sur nos étagères. Les entreprises désiraient, à juste titre, collecter et commencer à utiliser plus de données que jamais sur les produits, les personnes et les transactions.

Alors que la génération de données commençait à augmenter en flèche, il fallait trouver où les stocker. Andrew Brust, PDG/fondateur de Blue Badge Insights, explique : « Grâce à des technologies telles que Hadoop dans un premier temps, puis au stockage d'objets dans le cloud, ce qui constituait une ressource rare [les données] s'est transformé en une marchandise et l'on est passé de « Quels sont les quelques éléments qui méritent d'être analysés ? » à « Pourquoi ne pas conserver et explorer ces données ? »

« Ce qui constituait une ressource rare [les données] s'est transformé en une marchandise et l'on est passé de « Quels sont les quelques éléments qui méritent d'être analysés ? » à « Pourquoi ne pas conserver et explorer ces données ? »

— Andrew Brust, PDG/fondateur, Blue Badge Insights

Si le matériel et les serveurs en local offrent un certain niveau de sécurité, le stockage des données sur site peut se révéler coûteux et difficile à faire évoluer. Le stockage dans le cloud constituait une solution plus abordable et pouvait être géré par des tiers. De plus, entreposer des objets dans le cloud permettait de faciliter encore davantage le stockage Big Data, les données étant stockées sous forme d'objets et non de fichiers ou de blocs.

Résultat : une production massive de données combinée à un stockage apparemment infini. L'ère du Big Data a alors officiellement commencé.

Les dirigeants entraînent l'entreprise dans un tournant sans précédent

La dernière épreuve consistait à convaincre la direction que les données et l'analytique méritaient quelques investissements. Trop d'entreprises traitaient les données comme des souvenirs : on les gardait, mais leur côté pratique restait à prouver. Même si elles étaient en mesure d'obtenir les données spécifiques dont elles avaient besoin dans le bon format, pourraient-elles les analyser efficacement et assez rapidement pour contribuer utilement à la prise de décision ?

Trop d'entreprises traitaient les données comme des souvenirs : on les gardait, mais leur côté pratique restait à prouver.

Les dirigeants qui cherchent à développer leur entreprise sont toujours prêts à intervenir quand il le faut. Dans les années 1980, le rôle du directeur financier a pris de l'importance grâce aux initiatives des dirigeants visant à mieux gérer leurs actifs et leurs relations d'affaires en matière d'investissement. De même, le CMO est devenu un manager essentiel grâce à la complexité croissante des canaux marketing. Lorsque les résultats du progrès numérique ont commencé à parler d'eux-mêmes, les dirigeants se sont tournés vers le Chief Data Officer (CDO) pour promouvoir les données et l'analytique.

Tandis que les dirigeants prenaient conscience de la valeur de l'analyse de données, la mise en place de cette nouvelle fonction restait un processus non documenté. Les Data Scientists et les équipes analytiques coûtaient cher et étaient souvent difficiles à mettre en place. Trouver les bons talents revenait à chercher de l'or. Un morceau essentiel du puzzle semblait manquer…

C'est alors que la décennie a pris un tournant décisif. Destination : la démocratisation des données.

Les analystes devenus autonomes prennent le contrôle

C'est au début de la décennie que les logiciels dédiés aux données et à l'analyse ont commencé à gagner sérieusement du terrain pour tout ce qui va de la préparation et la fusion des données aux technologies de visualisation et de Business Intelligence. C'est également à cette époque qu'une société appelée SRC est devenue Alteryx. Ces technologies logicielles populaires apportaient des solutions à des processus analytiques de plus en plus complexes.

Ashley Kramer, vice-présidente directrice de la gestion des produits chez Alteryx, se souvient : « Avant, vous aviez un produit ou un outil distinct pour l'ETL d'entreprise, la préparation des données, le reporting, le catalogage des données, la visualisation et la modélisation. Maintenant, ils ont tous commencé à converger vers des plateformes uniques. »

La lourdeur des processus d'analyse et des outils existants qui n'étaient pas préparés au Big Data a fait de l'analytique un véritable casse-tête. L'essor des plateformes en libre-service nous a sauvés. Finis les tracas, et parce que les logiciels se sont occupés du codage et du back-end, l'analyse de données est devenue une affaire de « glisser-déposer ». La barrière à l'entrée pour les professionnels de la donnée et le coût de mise en place d'une équipe dédiée ont été presque réduits à néant, surtout si l'on tient compte de l'étonnant retour sur investissement des mesures à effet rapide.

Paige Bartley, analyste senior chez 451 Research, explique : « Les vannes des données et analyses en libre-service au sein des entreprises ont été ouvertes. Autrefois réservée aux experts techniques, l'exploitation des données s'est démocratisée. Des personnes ayant moins de compétences techniques peuvent faire émerger des insights à partir de données qui, dans le passé, étaient souvent dissimulées et accessibles à un nombre restreint d'initiés ».

« Les vannes des données et analyses en libre-service au sein des entreprises ont été ouvertes. »

— Paige Bartley, analyste senior, 451 Research

Le coût et le savoir-faire technique n'étaient plus des obstacles. Avec l'analyse en libre-service, l'IT est devenu un véritable partenaire. Non seulement les analystes pouvaient générer leurs propres données et lancer des projets plus rapidement, mais l'IT était libéré de ces demandes de données ad hoc qui monopolisaient constamment ses ressources.

« L'IT n'est plus le fournisseur d'analyses, de données et de rapports dans l'entreprise, mais le facilitateur », explique Chris Love, Account Manager chez The Information Lab. « Cela a permis aux analystes et aux métiers de réaliser eux-mêmes la préparation et la visualisation des données. » Avec des coûts et un délai d'exécution inférieurs, les équipes de direction n'ont pu être que convaincues. La transformation numérique, sous l'impulsion des données et de l'analytique, a déferlé dans les entreprises.

La libération du data worker a été totale, grâce aux plateformes en libre-service simplifiées. L'apparition de l'analyse en libre-service a sans aucun doute marqué la dernière décennie dans le domaine des données et de l'analyse de données.

Les années 2010 : la démocratisation des données

« Disons-le simplement, le plus grand changement de la dernière décennie a été la démocratisation de l'analyse de données. »

— Mark Frisch, PDG, Marquee Crew

« Une forme d'égalité a été établie grâce à l'accessibilité des outils et des plateformes d'analyse, ce qui permet aux utilisateurs de s'appuyer sur leur expertise non technique et sur les incroyables avancées techniques de la dernière décennie pour renforcer considérablement leur impact sur l'activité et la communauté. »

– Nicole Johnson, Sr. Business Solutions Consultant, T-Mobile

« Les données étaient cachées dans les méandres de l'équipe BI centralisée de la vieille école. Très peu de personnes savaient comment y accéder et les utiliser. Désormais, c'est un atout organisationnel clé qui s'est démocratisé et qui est facilement exploitable. »

— Heather Harris, directrice Intelligence et Analytique, ProKarma

« Grâce aux outils en libre-service éprouvés, testés et matures dont disposent aujourd'hui les « travailleurs de la donnée », nous sommes à l'âge d'or de la démocratisation des données. »

— Nick Haylund, directeur, Tessellation EMEA

« La démocratisation de la BI et de l'analyse de données constitue le plus grand changement de la dernière décennie dont je me souvienne. Atteindre les utilisateurs finaux change la donne. »

— AJ Guisande, directeur, Decision Science

Fin de la décennie

À la fin de la décennie, la valeur de l'analytique a atteint un sommet historique. Selon un rapport IDC, il y avait 54 millions de « travailleurs de la donnée » et les recettes générées par les solutions Big Data et analytiques ont atteint près de 200 milliards de dollars.

Tout le monde s'accordait à reconnaître la grande valeur des données, et ceux capables de leur donner du sens ont vu leur carrière décoller au point de devenir les champions des insights métier. Tout cela a contribué à préparer le terrain pour la prochaine décennie.

L'analyse de données du futur

Janvier 2020.Beaucoup de choses ont changé en dix ans. L'économie américaine a connu sa plus longue période de croissance depuis 1854 et dans le domaine des nouvelles technologies, l'iMac Pro d'Apple vient d'arriver dans les rayons. Tout comme il y a dix ans, vous vous demandez bien qui serait disposé à dépenser 52 400 dollars pour un ordinateur de bureau à roulettes alors que l'iPhone 11 Pro répond parfaitement à vos besoins.

Au cours de la décennie précédente, vous avez constaté un énorme changement dans la valeur des données et vous avez surfé sur la vague de l'analyse en libre-service. Aujourd'hui, vous avez atteint le sommet : votre connaissance du libre-service est un sceptre, vos insights disruptifs une couronne. La seule chose qui pourrait rendre la chose encore plus agréable serait de savoir ce qui va suivre.

Pour savoir ce que nous réservent les données et l'analytique, nous nous sommes tournés vers nos sources de données les plus crédibles, c'est-à-dire les leaders éclairés, notamment des analystes, les dirigeants d'Alteryx et nos clients inventifs. Voici leurs quatre prévisions majeures.

1. La datalphabétisation au centre

DES CADRES DANS LE DOMAINE DU BIG DATA ET DE L'INTELLIGENCE ARTIFICIELLE NE CONSIDÈRENT PAS ENCORE LES DONNÉES COMME UN ATOUT.

— Enquête sur le Big Data et l'intelligence artificielle, NewVantage Partners

Après le succès du libre-service dans le monde de la BI, les entreprises s'attendaient à des répercussions immédiates sur leurs activités, ou tout au moins à des signes apparents. Selon Andrew Brust, « Le combat est terminé, et l'évangélisation a pris fin. Maintenant que les dirigeants sont convaincus, la pression s'exerce sur les performances et les résultats. »

Nick Haylund, directeur de Tessellation EMEA, explique : « Si la technologie devient plus facile à utiliser, pourquoi les entreprises ne voient-elles pas le retour sur investissement qu'elles attendaient ? Bien qu'il soit toujours important d'avoir et de déployer les meilleures technologies pour les données et l'analyse, de nombreux départements et beaucoup d'entreprises négligent souvent d'investir du temps dans leur personnel et leurs processus. »

« Bien qu'il soit toujours important d'avoir et de déployer les meilleures technologies pour les données et l'analyse, de nombreux départements et beaucoup d'entreprises négligent souvent d'investir du temps dans leur personnel et leurs processus. »

— Nick Haylund, directeur, Tessellation EMEA

La mise au point d'une stack technologique jouera toujours un rôle secondaire par rapport à la prise d'autonomie derrière la technologie. Bien que ce ne soit pas un secret, l'on sous-estime largement le fait que la valeur des données résulte uniquement de l'utilisation de l'intelligence humaine. Tant que les analystes et les Data Scientists ne seront pas leur « porte-parole », les données resteront à jamais un ensemble de faits et d'observations muettes.

Bien que ce ne soit pas un secret, l'on sous-estime largement le fait que la valeur des données résulte uniquement de l'utilisation de l'intelligence humaine.

La véritable puissance des plateformes en libre-service ne réside pas seulement dans leur capacité à abaisser le seuil à partir duquel quelqu'un peut devenir analyste ou Citizen Data Scientist. Elles permettent également aux spécialistes du savoir, ou « knowledge workers » en anglais, d'enrichir leur travail dans tous les domaines d'activité avec des insights. Des ressources humaines à la finance, le principal atout de la technologie du libre-service est de permettre une culture de l'analyse.

Paige Bartley, de 451 Research, déclare : « Des employés aux parcours extrêmement variés pourraient désormais ajouter leurs propres points de vue à l'interprétation des données, ce qui permettrait une bien meilleure compréhension des performances et du potentiel du business ».

Au cours de la prochaine décennie, les données et l'analytique étant désormais accessibles au plus grand nombre, les entreprises dont les employés maîtrisent le mieux les données se démarqueront. Alan Jacobson, directeur des données et de l'analytique chez Alteryx, explique : « Les entreprises vont davantage se focaliser sur la formation en 2020 en vue d'améliorer leur transformation, car la croissance est plus rapide avec un CDO ou un rôle similaire pour piloter l'évolution de l'environnement de travail. L'entreprise connaissant bien le monde du numérique devance ses concurrents non numériques et 2020 ne fera que renforcer la tendance. En effet, davantage de sociétés vont tirer profit de leurs ressources numériques pour résoudre leurs problèmes. »

Et Ashley Kramer de poursuivre : « Les managers se mettront à promouvoir l'analytique et la Data Science en libre-service auprès de leurs employés. La direction doit faire preuve de conviction pour évoluer au-delà de l'approche archaïque de l'analyse et inciter à un changement culturel dans l'entreprise. »

À l'instar du leadership des dirigeants dans l'adoption de l'analytique, les initiatives de datalphabétisation viendront d'en haut. Pour être efficaces, ces initiatives devront être démocratisées dans toute l'entreprise.

Andy Uttley, responsable Conseil dans le groupe Javelin, explique : « La datalphabétisation n'est plus une compétence demandée par seulement quelques personnes. Désormais la plupart y tiennent, et pour assurer le succès de l'entreprise il faut impérativement être capable de comprendre et d'utiliser les données à tous les niveaux. »

Il y a toutefois un bémol. Andy Uttley explique que la démocratisation des données et l'essor du libre-service font émerger de nouveaux défis, car « mettre les données entre les mains de toutes les personnes concernées peut accroître les risques : gouvernance des données, modèles surdimensionnés ou inappropriés émanant de personnes non qualifiées, ou erreurs incluses dans les sources de données utilisées dans toute l'entreprise par manque de formation ou de compétences. »

Le fait que dans le monde des affaires, les professionnels puissent manipuler des données présente le risque d'une utilisation incorrecte, inappropriée, voire contraire à l'éthique. À mesure que les données gagneront du terrain, des directives pour les entreprises et la protection des consommateurs seront établies. La datalphabétisation doit constituer une priorité dans le planning des dirigeants pour deux raisons : la transformation de l'entreprise et la gouvernance.

La datalphabétisation doit constituer une priorité dans le planning des dirigeants pour deux raisons : la transformation de l'entreprise et la gouvernance.

Paige Bartley ajoute : « L'éthique de l'utilisation appropriée des données deviendra un sujet sociétal dans l'air du temps. Beaucoup prétendent que « les données sont le nouveau pétrole » et que cette métaphore va au-delà de la valeur monétaire superficielle de la ressource en question. Tout comme l'exploitation des ressources naturelles résultant de la révolution industrielle a conduit à la sensibilisation à l'environnement et à l'activisme, l'activisme lié à la protection de la vie privée et à l'éthique des données constituera une réponse à l'exploitation des ressources personnelles et informationnelles que l'on connaît actuellement avec la révolution numérique. »

2. L'essor des « enfants de la data », ou « Data natives »

En plus de la datalphabétisation et de la maîtrise des données, une nouvelle génération va apparaître, celle qui grandit autour des données et que l'on appelle « data native », autrement dit les « enfants de la data ». Tout comme les enfants du numérique ont grandi entourés de smartphones et de technologies numériques, les enfants de la data ne sauront pas qu'il y a eu un avant Fitbit, Nest et Propeller.

« Les jeunes générations qui s'adaptent et apprennent rapidement vont exceller alors que de nouvelles compétences en langage, données et analytique seront de plus en plus recherchées », déclare Andy Uttley. « Je pense donc que nous devrions assister à un changement de cap partant de la base et attendre, voire provoquer, des changements dans le système éducatif afin de mieux préparer les enfants au monde qui les attend. Cela devrait inclure une meilleure capacité à résoudre des problèmes et, bien sûr, des compétences obligatoires dans des langages tels que Python ».

Les nouvelles générations baigneront toujours dans un monde de données et d'analyse. Selon Ashley Kramer, SVP Solutions produit, « de nouvelles entreprises sont focalisées sur la datalphabétisation, et nous voyons l'analyse de données prendre toujours plus d'ampleur dans les universités du monde entier ». Citons par exemple l'université d'État de l'Arizona, avec laquelle Alteryx vient de s'associer pour lancer des initiatives de ville intelligente dans la région métropolitaine de Phoenix.

Mais qu'est-ce qui va changer pour ceux d'entre nous qui ne font pas partie des « enfants de la data » et qui ont appris à utiliser les données à l'ancienne ? Alors qu'au début de la décennie précédente les données étaient traitées comme des souvenirs à collectionner, cette décennie les verra revêtir un langage propre. Le jargon analytique deviendra un langage primaire, intégré dans la langue des affaires.

3. PRÉDICTION DE L'ANALYSE PRÉDICTIVE

Si, au cours de la décennie précédente, nous avons parfaitement géré la préparation et la fusion des données, au cours de la prochaine décennie nous viendrons à bout de l'analyse prédictive et prescriptive (avec l'aide de nos amis que sont l'intelligence artificielle et le machine learning.

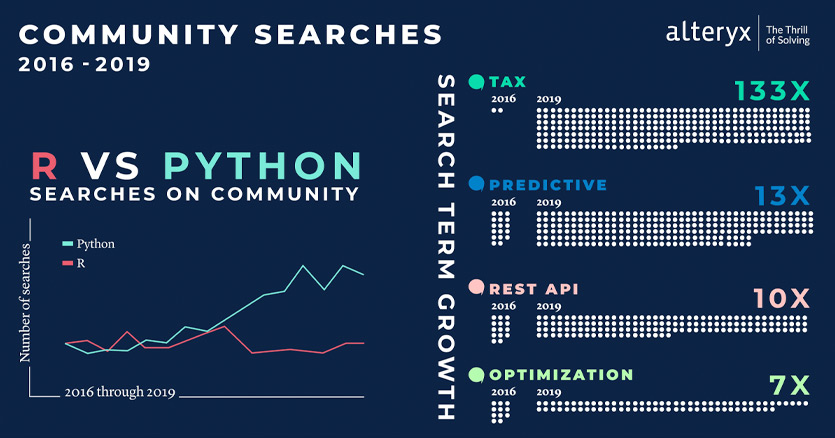

Les données sur les recherches effectuées dans notre Communauté confirment l'intérêt grandissant pour l'analyse prédictive et le machine learning :

Comme l'indique Jarrod Thuener, Chief Analytics Officer chez Kristalytics, « au risque d'employer abusivement une autre expression à la mode, nous entrons dans l'ère du machine learning. Il s'agit en fait d'utiliser les données que nous collectons. Il est essentiel de pouvoir agir en fonction des analyses, et bientôt, nous disposerons de systèmes d'autosurveillance dans lesquels une boucle de rétroaction continue orientera les décisions en aval. »

N'imaginez pas 2025 comme une année cauchemardesque où les machines auront pris le contrôle sur les humains. Dean Stoecker croit que nous devrions tous avoir un peu plus foi en nous-mêmes : « Si vous pensez que l'intelligence artificielle va gagner la partie, détrompez-vous. Si nous amplifions l'intelligence humaine, l'unicité ne verra jamais le jour ! L'humanité n'a pas dit son dernier mot. »

Bien que les données alimentent les modèles de machine learning, ce seront les humains qui aideront à la sélection des données et aux applications de leur utilisation. L'intelligence artificielle, ou « stupidité artificielle » comme on l'appelle parfois lorsqu'Alexa, Google Home ou Siri ne comprend pas ce que nous voulons, même si c'est simple comme bonjour, tient ses performances de celles des humains qui sont derrière. Nous ne pourrons jamais remplacer l'art par les mathématiques, la musique par le code ni le contact humain par un algorithme. Selon Alan Jacobson, l'intelligence artificielle et le machine learning sont là pour « augmenter », pas pour remplacer.

« L'intelligence artificielle et le machine learning sont là pour augmenter, pas pour remplacer. »

— Alan Jacobson, Chief Data and Analytics Officer, Alteryx

Ensuite, poursuit Alan Jacobson, nous allons passer d'une focalisation sur les langages et le codage derrière le machine learning, l'intelligence artificielle et l'analyse prédictive à la démocratisation de ces technologies, tout comme nous l'avons fait en démocratisant l'accessibilité des données au cours de la dernière décennie. « Depuis 2019, les technologies de modélisation et de traitement du langage sont robustes, mais pas packagées pour être accessibles. Lorsque tout le monde, de l'analyste métier au data scientist, bénéficiera d'une totale accessibilité, de réelles améliorations se feront rapidement sentir. »

Tout comme l'essor de la datalphabétisation, l'essor de l'analyse avancée accessible s'accompagne de nouveaux défis en matière de gouvernance. Paige Bartley, analyste senior chez 451 Research poursuit : « Paradoxalement peut-être, nous devons exploiter la Data Science et l'analyse des données afin de mieux comprendre les effets d'une utilisation croissante de l'automatisation et des systèmes algorithmiques sur l'interaction et le comportement humains dans le monde. Nous pouvons désormais quantifier presque tous les aspects du comportement humain et en tirer des enseignements utiles. Nous avons besoin de mieux comprendre les ramifications potentielles de notre utilisation systématique de la technologie avant de pouvoir l'utiliser pour progresser en tant que société. »

Dean Stoecker est convaincu que même des problèmes complexes comme ceux-ci peuvent être résolus grâce à la magie des données combinée à l'intelligence humaine. « Si nous pouvons résoudre un problème en utilisant les bonnes données, alors nous pouvons résoudre tous les problèmes », conclut-il. « Le seul moyen de relever ces défis sera d'amplifier l'intelligence humaine afin de savoir quelles questions poser ».

4. L'analytique au service de l'intérêt général

Pour conclure cette réflexion sur la prochaine décennie, nous avons demandé à notre communauté de leaders éclairés quels problèmes mondiaux ils aimeraient résoudre avec les données et l'analytique. Voici quelques-unes de leurs réponses :

« J'aimerais contribuer à des initiatives en faveur de la paix dans le monde. Oubliez les armes et aidez plutôt les jeunes à se lancer dans l'analyse de données. Faites des modèles, pas la guerre. »

— Mark Frisch, PDG, Marquee Crew

« Lutte contre le changement climatique, analyse et optimisation de l'enseignement public, limitation du nombre de sans-abri et fin de l'isolement social. »

— Heather Harris, directrice Intelligence et Analytique, ProKarma

« Étude sur les jeunes filles et femmes de 11 ans et plus : quelles statistiques ou quels choix de vie expliquent qu'elles excellent dans l'industrie technologique, quel que soit le poste. Plus analyse comparative inné-acquis, mais d'un point de vue technologique. »

— Sharmila Mulligan, responsable de la stratégie, Alteryx

« Éducation. Un problème demeure : une très grande partie de la population est sous-qualifiée. Plus nous pouvons avoir recours à la technologie pour comprendre et permettre l'apprentissage, plus les bénéfices s'accumulent pour nous tous, puisqu'une planète mieux éduquée est plus stable économiquement et améliore la prise de décision ».

— Sean Adams, SVP et directeur général, Multinational Investment Bank

« Les scénarios médicaux constituent une excellente application de la Data Science et de l'analyse de données. Viser plus haut et appliquer ces scénarios aux questions du changement climatique et des affaires internationales devrait être un objectif à se fixer, aussi audacieux soit-il. Nous devons également nous intéresser à l'éthique, sinon le contraire se produira : l'intelligence artificielle servira plus à la guerre qu'à la paix et à des actions constructives. »

— Andrew Brust, PDG/fondateur, Blue Badge Insights

« Répartition de la pauvreté dans le monde. »

— AJ Guisande, directeur, Decision Science

« Si je ne devais choisir qu'un seul problème à résoudre, ce serait celui du cancer de l'enfant. »

— Michael Barone, Data Scientist, Paychex

« La santé et l'utilisation du machine learning pour améliorer les résultats en matière de santé, comme la recherche sur le cancer et les alertes prédictives ».

— Adrian Loong, Manager Data Science, Datacom

« Les inégalités dans la société et le recours à l'analytique pour améliorer la mobilité sociale. »

— Joseph Serpis, Consultant, Keyrus

Destination 2030 et au-delà

L'analyse en libre-service a révolutionné la décennie précédente. Elle est sur le point de bouleverser également la prochaine, mais pour des raisons totalement différentes. Les choses vont-elles se dérouler comme nous l'avons prévu ? L'avenir nous le dira. Enfin, à moins que vous n'ayez déjà utilisé l'analyse de données pour construire une machine à voyager dans le temps… ce qui serait fabuleux.

NE PARTEZ PAS.

Lecture

« Une décennie d'inspiration » retrace les moments forts qui ont marqué la communauté Alteryx au cours de la dernière décennie.

AUDIO

Dans le podcast « Alteryxer la décennie » d'Alter Everything, Libby Duane Adams, cofondatrice et CCO d'Alteryx, ainsi que deux employés de longue date partagent leurs réflexions sur de nombreux sujets, depuis le premier bureau d'Alteryx jusqu'à l'avenir de l'analytique.

À PARTAGER

Racontez-nous les moments les plus mémorables de la dernière décennie en matière d'analytique en vous adressant à @alteryx.